Відмінності між версіями «Ядерне згладжуваня»

Vova (обговорення • внесок) (Створена сторінка: '''Ядерное сглаживание''' - один из простейших видов [[Непараметрическая регрессия|непарам…) |

Vova (обговорення • внесок) (→Постановка задачи) |

||

| Рядок 3: | Рядок 3: | ||

== Постановка задачи == | == Постановка задачи == | ||

| − | :Решается задача восстановления регрессии. Задано пространство объектов < | + | :Решается задача восстановления регрессии. Задано пространство объектов <math>X</math> и множество возможных |

| − | ответов < | + | ответов <math>Y=R</math>. Существует неизвестная целевая зависимость <math> y^*: X \rightarrow Y</math>, |

| − | значения которой известны только на объектах обучающей выборки < | + | значения которой известны только на объектах обучающей выборки <math> X^m={(x_i, y_i)}_{i=1}^m</math>. |

| − | Требуется построить алгоритм < | + | Требуется построить алгоритм <math>a: X \rightarrow Y </math>, аппроксимирующий целевую зависимость <math>y^*</math>. |

== Принцип == | == Принцип == | ||

Версія за 18:17, 13 березня 2012

Ядерное сглаживание - один из простейших видов непараметрической регрессии.

Зміст

[сховати]Постановка задачи

- Решается задача восстановления регрессии. Задано пространство объектов [math]X[/math] и множество возможных

ответов [math]Y=R[/math]. Существует неизвестная целевая зависимость [math]y^*: X \rightarrow Y[/math], значения которой известны только на объектах обучающей выборки [math]X^m={(x_i, y_i)}_{i=1}^m[/math]. Требуется построить алгоритм [math]a: X \rightarrow Y[/math], аппроксимирующий целевую зависимость [math]y^*[/math].

Принцип

Принцип, используйщий идейно простой подход к представлению последовательности весов <tex>\{ W_{mi}(x) \}_{i=1}^m</tex> состоит в описании формы весовой функции <tex>W_{mi}(x)</tex> посредством функции плотности со скалярным параметром, который регулирует размер и форму весов около х. Эту функцию формы принято называть ядром <tex>K</tex>.

Полученные таким образом веса далее используются для представления величины <tex>a(x)</tex> в виде взвешенной суммы значений <tex> y_i</tex> обучающей выборки.

Описание метода

Определение ядра

Ядро — это непрерывная ограниченная симметричная вещественная функция <tex>K</tex> с единичным интегралом

- <tex>\int K(u)du=1</tex>

Последовательность весов

Последовательность весов для ядерных оценок (для одномерного <tex>x</tex>) определяется как ::<tex>W_{mi}(x)=\frac{K_{h_m}(x-X_i)}{\hat{f}_{h_m}(x)}</tex>, где

- <tex>\hat{f}_{h_m}(x)=\frac1m \sum_{i=1}^m K_{h_m}(x-X_i)</tex>,

a

- <tex>K_{h_m}(u)=\frac{1}{h_m} K\(\frac{u}{h_m}\)</tex>

представляет собой ядро с параметром <tex>h_m</tex>. Этот параметр принято называть шириной окна. Подчеркнув зависимость <tex>h\ =\ h_m</tex> от объема выборки <tex>m</tex>, условимся сокращенно обозначать последовательность весов <tex>W_{mi}(x)</tex>.

Функция ядра

Функция <tex>\hat{f}_{h_m}(x)</tex> является ядерной оценкой плотности Розенблата — Парзена (Rosenblatt, 1956; Parzen, 1962) для (маргинальной) плотности переменной <tex>x</tex>. Данный вид ядерных весов <tex>W_{mi}(x)</tex> был предложен в работах (Nadaraya, 1964) и (Watson, 1964). Как следствие, оценка ожидаемой величины восстанавливаемой зависимости <tex>E(y\|x)</tex>:

- <tex>\hat{m}_h(x)=\frac{\frac1m\textstyle\sum\limits_{i=1}^m K_{h_m}(x-X_i)Y_i}{\frac1m\textstyle\sum\limits_{i=1}^m K_{h_m}(x-X_i)}</tex>

часто называют оценкой Надарая—Ватсона. Ширина окна определяет, насколько быстро убывают веса <tex>W_{mi}(x)</tex> по мере удаления объектов <tex>x_i</tex> от <tex>x</tex>. Характер убывания определяется видом ядра <tex>K</tex>. Нормализация весов <tex>\hat{f}_{h_m}(x)</tex> гарантирует, что сумма весов равна единице.

Замечание. При ряде условий имеет место сходимость по вероятности данной оценки к <tex>E(y|x)</tex>.

Пример функции ядра

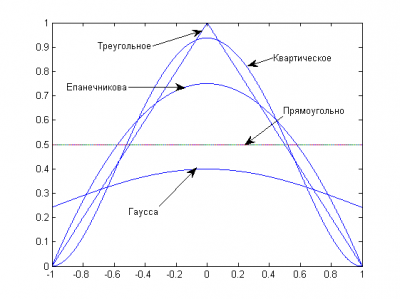

На практике используется несколько видов ядерных функций. Чаще всего используется квартическая ядерная функция

- <tex>K(u)=(15/16)(1-u^2)^2I(\| u \| \le 1)</tex>.

Также используется ядро Епанечникова, обладающее некоторыми свойствами оптимальности [Хардле В п4.5]; это функция параболического типа (Epanechnikov, 1969; Bartlett, 1963):

- <tex>K(u)=0.75(1-u^2)I(\| u \| \le 1)</tex>.

Другими примерами являются ядро Гаусса,

- <tex>K(u)=(2\pi)^{-1/2} \exp(-u^2/2)</tex>,

треугольное ядро

- <tex>K(u)=(1-\|u\|)I(\| u \| \le 1)</tex>,

и прямоугольное ядро

- <tex>K(u)=(1/2)I(\| u \| \le 1)</tex>.

Замечание. Точность восстанавливаемой зависимости мало зависит от выбора ядра. Ядро определяет степень гладкости функции <tex>a(x)</tex>.

Зависимость от ширины окна

Выбор окна решающим образом влияет на точность восстанавливаемой зависимости. При чересчур малых значениях <tex>h</tex> кривая <tex>a(x)</tex> стремится пройти через каждую точку выборки, остро реагируя на шумы и претерпевая резкие скачки, поскольку в этом случае оценка опирается только на небольшое число наблюдений из узкой окрестности точки <tex>x</tex>. Наоборот, если ширина окна велика, функция чрезмерно сглаживается и в пределе при <tex> h \rightarrow \infty</tex> вырождается в константу -- усреднённое значение величин <tex> y_i</tex>. В этом случае сглаженная функция не даёт возможности определить характерные особенности искомой зависимости <tex> y^*(x)</tex>.